7月2日晚上10点之后,负责的服务(redis.clients.jedis.exceptions.JedisConnectionException)中发生了大量Redis连接超时异常,因为数据库查询在Redis中缓存了2分钟,并且没有降级已经完成。采取措施后,并不能做限流处理,并且随着中午高峰时间的流量猛增,并且QPS从10点开始达到2000,在11点时达到了13000 QPS的峰值。

幸运的是,redis超时导致的某些查询失败不会导致整个主链接过程不可用,因此下一步就是如何快速查找和解决问题。 1.首先与负责redis的同学核对,首先消除redis本身的问题。

2.如果在独立维度上可以看到服务自检的异常分布,请切换到独立维度以检查异常是否均匀分布。如果分布不均匀,则只有少量主机非常高,您基本上可以找到发生问题的计算机的Redis负载。

根据传统经验,检查redis集群的节点负载是否过高,例如80%。如果超过一个或少量节点,则表明存在“热键”。

问题。如果大多数节点超过它,则意味着存在“降低总体压力”的问题。

检查监视慢请求。如果慢速请求的时间与问题发生的时间匹配,则可能存在“大键”。

问题。客户端的几个常见原因是:CPU进程,GC,网络容器,主机,CPU,观察机器或容器的CPU:CPU(100%)是否接近或超过80%CPU电流限制。

是否有密集电流限制或长期电流限制。如果存在这些现象,则应该是“计算资源不足”的问题。

处理GC频繁使用GC或GC消耗时间太长将导致无法安排线程及时读取redis响应。通常是每分钟的总GC持续时间/ 60s /每分钟的GC数量。

如果达到ms级别,则对redis的读写延迟的影响将很明显。然后,比较与以前的正常时间相比是否有明显增加。

通常可以通过监视TCP重传速率来测量网络质量。比率越低越好。

如果TCP重传率保持在0.02%以上(基于您的实际情况),或者其突然增加,则可以确定这是否是“网络问题”。我的问题在这里,我实际上发现该容器的TCP重传率非常高,有的甚至达到了0.6%。

向容器咨询的同事建议重新启动容器,并在重新启动后立即解决问题。继续谈论疑难解答的想法。

容器主机监视容器主机的CPU状况。在某些情况下,该计算机是虚拟机,并且CPU的监视指示器可能不准确,尤其是在io密集型情况下。

可以通过OPS提供的其他方式查询。由于机密性问题,无法放置该问题的屏幕截图,但这实际上是一个警钟。

关键链路中必须确保保险丝电流限制和降级措施。重要的事情说了三遍,需要X3。

!而且原始的历史代码本身也有一些问题。一年中的大部分时间都不会共享缓存的数据。

根本不需要Redis缓存。内存级别的缓存就足够了,或者内存缓存+ redis也用作级别缓存一个更合理的计划。

在正常开发中,我们必须充分考虑数据的及时性,以进行相应的设计。

公司: 深圳市捷比信实业有限公司

电话: 0755-29796190

邮箱: ys@jepsun.com

产品经理: 汤经理

QQ: 2057469664

地址: 深圳市宝安区翻身路富源大厦1栋7楼

更多资讯

获取最新公司新闻和行业资料。

- double sum = 0.0; for(int i = 0; i < n; i++) { if(resistors[i] > 0) { sum += 1.0 / resistors[i]; 在C语言中计算并联电阻的总电阻是一个常见的应用问题,它涉及到基本的物理知识与编程技巧的结合。并联电路中的总电阻可以通过所有并联电阻倒数的和的倒数来计算。首先,我们需要定义一个函数来处理这一计算过程。例如...

- 1安铅保险丝直径约0.5至0.8毫米 铅保险丝的直径与所需通过的最大电流有关。一般来说,用于1安培电流的铅保险丝直径大约在0.5毫米到0.8毫米之间,但具体尺寸还需参照实际产品的规格表或制造商提供的数据。因为不同制造商可能有略微不同的设计标准和材料...

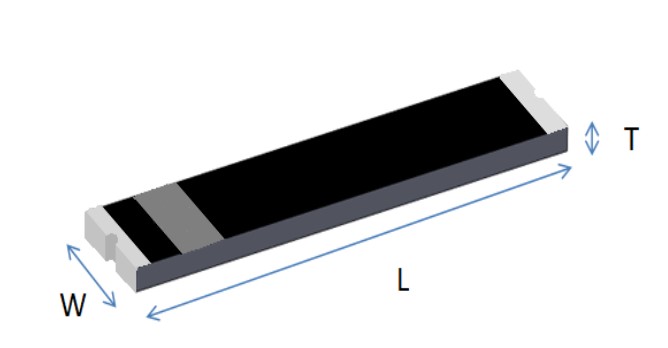

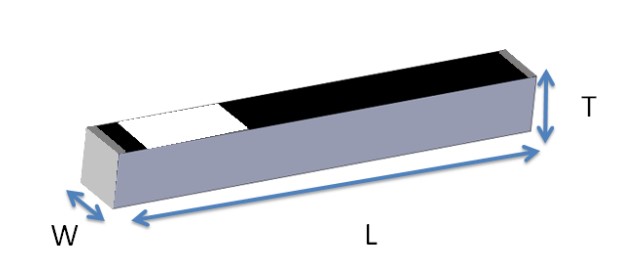

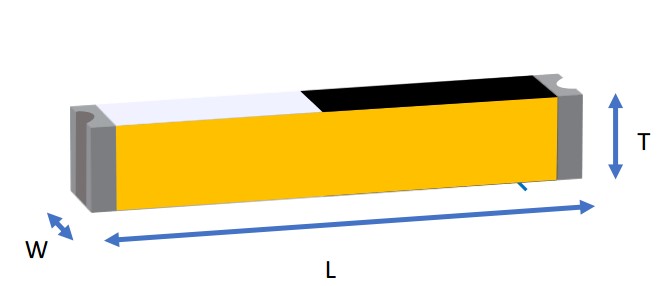

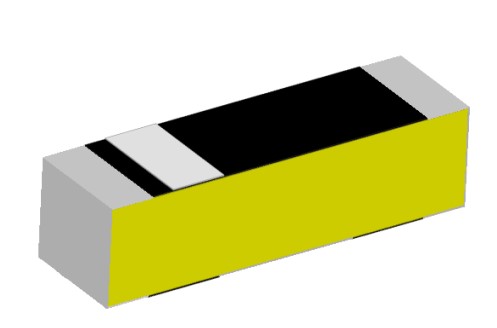

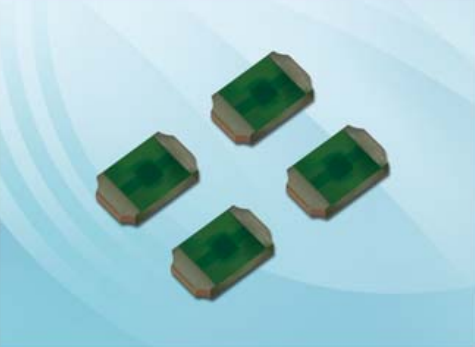

- 从0.6X0.3mm到0.8X0.8mm:深入对比两种Chip SMD封装规格 Chip SMD-0.6X0.3mm 与 0.8X0.8mm 封装性能对比在电子元器件选型中,Chip SMD-0.6X0.3mm 和 0.8X0.8mm 是两种极具代表性的超小型封装形式。它们虽同属表面贴装技术,但在尺寸、应用场景及制造难度上存在明显差异。1. 尺寸与物理特性对比 参...

- PT100热电阻温度与电阻值对照表(0°C基准0.385) 根据PT100热电阻的标准特性,其电阻值随温度变化而变化,通常基于0°C时电阻为100Ω作为参考。对于给定的温度系数α=0.385Ω/°C(这指的是每度变化的电阻增量),我们可以构建一个简化版的对照表来展示特定温度下对应的电阻值...

- 如何测量0.68uf安规电容 要测量0.68uf的安规电容,首先需要确保电容已经从电路中拆卸下来,并且完全放电。使用数字万用表的电容测量功能,将表笔分别接触电容的两个引脚,读取显示屏上的数值。如果读数与标称值0.68uf相近,则说明该电容正常。需...

- 如何正确选型与焊接SMD-1.6X0.8mm LED灯珠与0.068μF电容?实用指南 前言:小尺寸元器件的装配挑战在现代PCB设计中,1.6×0.8mm的SMD LED灯珠与0.068μF电容虽体积微小,但其性能关键。若选型不当或焊接失误,极易导致短路、虚焊或功能异常。本文将从选型标准、焊接工艺到测试方法进行全面指导。...

- 数字万用表测量电阻时显示0的可能原因与解决方法 当使用数字万用表测量电阻时,如果显示屏上出现“0”,这通常意味着万用表检测到了一个非常低的电阻值或者短路。以下是几种可能的原因及相应的解决方法:1. 测试对象实际具有非常低的电阻:如果被测物体本身就是一个低...

- 电阻为0时的电导特性及超导体的应用 在物理学中,电阻和电导是表征物质对电流阻碍作用的两个物理量。其中,电阻(R)是指电流通过物体时遇到的阻力大小,单位是欧姆(Ω),而电导(G)则是电阻的倒数,表示物体导电的能力,单位是西门子(S)。如果某个物...

- 关于电容补偿柜功率因数显示为负0.99的问题分析 在电力系统中,电容补偿柜的主要功能是提高系统的功率因数,从而减少能量损失和提高供电效率。当提到电容补偿柜的功率因数显示为-0.99时,这通常意味着系统可能存在异常情况。正常情况下,电容补偿柜应该使功率因数接近...

- 电阻精密度1%能代0.1%吗? 不能!其实,对于不是搞计量的不需要分的那么清楚,可以大体上认为高精密、高准确、低误差等是一个意思。但是,对于“精度”一词,可以分解成分解成三个要素: 1 、温度系数:温度变化是电阻的大敌,温度系数一...

- 如何根据系统需求选择合适的参考电压组件:0.6V vs 1.24V 从系统级设计视角看0.6V与1.24V参考电压组件的选型策略在嵌入式系统、传感器接口电路以及电源管理芯片设计中,参考电压组件的选择直接影响系统的可靠性与能效表现。本文将从多个维度深入剖析0.6V与1.24V参考电压组件的选型...

- 电感对地阻值为0时的可能原因与解决策略 在电子电路中,电感器对地的阻值测量结果为0欧姆,通常表明电感器可能存在短路问题。这种情况可能是由于电感器内部线圈发生短路,或者外部电路存在短路导致的测量误差。解决此类问题的方法包括更换损坏的电感器、检查...

- 大毅合金电阻授权代理商RLP25FEER220 2512 1% 2W 0.22R 加工定制否品牌TA-I型号RLP25FEER220种类高精度合金电阻性能取样合金电阻材料合金制作工艺合金制程工艺外形贴片允许偏差1%温度系数50ppm-100ppm额定功率2(W)功率特性大功率频率特性中频产品性质耐高温 合金电阻货号21+是否跨境...

- 0欧电阻能过多大电流? 在电路设计和电子学领域,0欧姆电阻是一个看似矛盾但实际上有着多种用途的元件。理论上,0欧姆电阻意味着没有电阻,可以允许无限大的电流通过。然而,在实际应用中,这样的情况是不可能实现的,因为任何导体都会有一定...

- 0.75KW三相电机改接单相时所需电容大小的选择 将一台0.75KW的三相电机改接为单相供电时,需要额外添加启动电容以确保电机能够正常启动和运行。选择合适的电容容量对于保证电机性能至关重要。一般而言,计算所需的电容值可以通过以下公式进行估算:C(μF) = (P(KW) * 100000...

- 如何在Multisim 14.0中找到电阻 在使用Multisim 14.0进行电路设计和仿真时,找到并正确使用电阻元件是十分重要的。电阻作为最基本的电子元件之一,在电路中用于限制电流或分压。要在Multisim 14.0中找到电阻,请按照以下步骤操作:1. 打开Multisim软件,创建或打...

- 0欧姆电阻:连接、调试与安全保护的多功能元件 0欧姆电阻在电路设计中看似无用,实则具有多重功能。首先,它可以用作跳线或连接器,方便电路板的调试和维修时快速断开或连接电路。此外,在生产制造过程中,0欧姆电阻可以作为占位符,预留位置以便后续需要增加组件时...

- 数字万用表测量电容显示0的原因及解决方法 当使用数字万用表测量电容时,如果显示屏上显示0,可能的原因有以下几种:1. 电容已损坏:如果电容内部发生短路或开路故障,万用表将无法正确测量其电容值。2. 测量范围选择不当:数字万用表通常有多个电容测量范围,如...

- 如何正确安装超小封装超级电容?实用指南与常见问题解答 超小封装超级电容安装全流程详解近年来,超小封装超级电容因其兼具高能量密度与快速充放电特性,被广泛应用于备用电源、数据保持电路和瞬时功率补偿系统中。本文将从安装流程、技术难点到常见错误逐一剖析。一、选择...

- 50W无感电阻与0.5W电阻能否用5W电阻替代?全面解析功率匹配问题 50W无感电阻与0.5W电阻能否用5W电阻替代?技术解析在电子电路设计中,电阻的功率额定值是一个至关重要的参数。当面对实际选型时,常有疑问:是否可以用更高功率的电阻(如5W)替代原本标称0.5W或50W的无感电阻?本篇文章将...